時間:2017-06-04 來源:互聯網 瀏覽量:

近日,微軟研究院公布的一篇新論文提出了一種新架構,它的內部表征(在執行文本問答任務時)可以用語言學基本理論的基本概念來進行解釋。這一方式成功地在幾乎不損失性能的情況下讓深度神經網絡具備了可解釋性。該論文作者鄧力等人撰文詳解了這一新方法的原理和意義。

今天,人們正在越來越多的事物上接受來自人工智能係統的建議,其中包含歌曲推薦、股票選擇甚至癌症診斷。在獲得建議的同時,人們希望了解 AI 係統做出決策的原理,但目前,對於生成機製的解釋顯然是不存在的。這是因為絕大多數當今頂尖性能的 AI 係統都包含一類關鍵組成部分「人工神經網絡」,而即便是對於著名研究機構中負責創造人工神經網絡的大師們而言,人工神經網絡的決策也是不可解釋的。

人工神經網絡是一套被設計用來模仿我們所認為的人腦如何存儲和處理信息的軟件。觀察人工神經網絡的內部以理解它的決策,正如觀察人腦內部一樣令人困惑:你所看到的是大量通向各個方向的連線,它們連接著所有微小的計算單元——「神經元」。每個神經元從指向它的連線上收集信號,對所有信號組成的激活水平求和,然後通過由它出發的連線去傳遞關於自身激活水平的信號。那些連線是從網絡在自身在處理信息的時候所產生的「學習經驗」中形成的;並沒有程序員對這些連線去施加一個可理解的秩序;通過查看這些連線來區分網絡從經驗中學習到的東西已被證明是無效的,而且也目前看來這條路在未來缺乏希望。

在這種情況下,我們或許應該轉變思路。構建一種新型人工智能係統可以改變我們對於處理過程不可知的窘境。這個新型 AI 係統架構不僅被設計來模擬我們在人腦中觀察到的線路叢林,也能顯示當我們窺視意識時所觀察到的各種概念、思想以及規則所交織形成的網絡。這種新的 AI 方法被稱為「意識/腦 網絡(mind/brain networks):類腦神經網絡」,它通過意識級別的組織切入神經的複雜機製,構建可理解和可互通係統:那是一個我們用來思考和討論 AI 係統解決問題的概念的層次。

微軟研究院最新的一篇論文《Deep Learning of Grammatically-Interpretable Representations Through Question-Answering》報告了關於意識/腦網絡架構的概念證明推理。

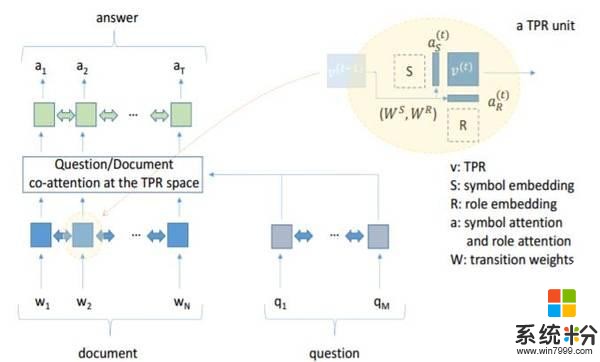

微軟提出的全新 AI 係統會回答以英文文本提出的問題;每個問題都涉及到維基百科中的特定段落,它們和問題一起被提供給係統。係統會找到一個由給定段落中的文本片段組成的答案。係統內部的大多數組成部分都是不可理解的典型神經網絡技術模塊。但關鍵的是,在這個架構加入了一個全新的組成部分——一個意識/腦網絡模塊;它被稱為 TPRN(由於技術原因,它的全稱是「Tensor-Product Recursive Network,張量乘積遞歸網絡」)。

TPRN 給人工智能係統提供了一個白板,係統可以學習著在它上麵去書寫符號。係統擁有 100 個可以以任何合適的方式來使用的空白符號。正如我們可以在一個句子裏麵以不同的角色類型去加入單詞一樣——Jay 可以出現在 Jay gave Kay's book to Bea 中(Jay 把 Kay 的書給了 Bea,主語角色),或者出現在 Kay gave Jay's book to Bea(Kay 把 Jay 的書給了 Bea,擁有者角色),或者出現在 Bea gave Kay's book to Jay 中(Bea 把 Kay 的書給 Jay,接受者角色)......——AI 係統也可以以不同的角色去放置這些符號;係統被給定了 20 個空白的角色來以它所選擇的任意方式去放置符號。在 TPRN 係統中,每一個符號和角色都以一段代碼的形式出現——大約是超過 10 個神經元興奮的模式;係統關於將特定的符號置於特定的角色的決策在 TPRN 中以超過 100 個神經元的代碼出現。這些代碼都是係統自己學習生成的。當針對一個給定的段落提問時,係統會為問題和段落中的每一個單詞從這些超過 100 個神經元的代碼集合中分配一個專用於這個單詞。然後所有的這些代碼都被傳遞到由標準的(難以理解的)人工神經網絡意識所構建的係統的剩餘部分。

我們希望這個網絡能夠學會用它自己的符號去表征複雜的、抽象的意義,並學習使用它自己的角色去表達我們在單詞遊戲中看到的各種不同的功能(如主語、賓語等)。這正是 TPRN 所做的。通過學習,一個符號代表「profession」的意思,另一個代表「eographical unit」的意思,另一個代表「所有可能成為的形式」,另一個代表「人名」,另一個代表「月份」...... 事實上,通常一個符號會代表數個這種含義;這也是我們預料之中的,因為它要用僅僅擁有的 100 個符號去覆蓋它所麵對的各種維基百科條目中的所有含義。

最有趣的是 TPRN 所學習到的角色,(事實上,角色就是意識/腦網絡的關鍵創新之一)。很多角色都可以根據語言學理論中的概念來解釋。這些概念適用於很多不同層次的語言,TPRN 的角色與 5 個不同層次的語言概念相對應,從單詞級別的「複數」到前文提及的短語扮演主語和賓語的不同情況。

簡而言之,TPRN 成功地學習到了一些類似於語言學家所確定的語法概念。至關重要的是,它僅僅通過基於問題、源文本以及答案的經驗就做到了這一點:他並沒有內在的語言學知識,接收到的訓練數據都是沒有語法標注的文本(它從沒有被告知「這是一個主語」),它從沒有執行過一個和語法概念相關的任務。它在那種和孩童學習他們第一個語言相同的環境下進行學習,並且這些結果增加了這一有爭議的主張的可信度:語言學家的抽象概念確實對應著說話人意識中的一些元素。

那麼,所有這些與解釋的當前人工智能係統的決策機製有什麼關係呢?在很大程度上,解釋了意識/腦網絡的符號和角色的概念意義之後,解釋整個 AI 係統行為的某個方麵就變得有可能了。結果證明,當 who 出現在 Doctor Who(著名英劇:神秘博士)這個詞組中時,TPRN 對單詞 Who 經常會選擇錯誤地符號。它錯誤地為單詞 who 選擇了和類似於問句「Who was the first emperor of China」中 who 的意思一樣的角色。當然,這讓它更容易給出錯誤的答案,因為它會認為「What type/genre of TV show is Doctor Who,Doctor Who 是一個什麼類型/流派的電視節目」是一個「問是誰」的問題,而事實上這是一個「問是什麼」型的問題(它曾經給出的一個錯誤的答案就是「time lord,時間領主」)。事實上 TPRN 確實會在此類問題上出現比那些為一個名字分配正確的 who 符號的場景更多的錯誤。

這可能是第一次有可能為一個抽象的神經網絡的內部激活模式做出有意義解釋,那種可以作為網絡決策的一部分的解釋。這僅僅是某些新事物(有意義的工作)的開始。但是,嚴肅地講,一個新方向已經出現了。

論文:Deep Learning of Grammatically-Interpretable Representations Through Question-Answering

論文鏈接:http://arxiv.org/abs/1705.08432

摘要:我們提出了一種新的架構,用以表示深度神經網絡端到端優化在文本問題解答任務中的內部機製,這一機製可與基本語言學理論相通。這種可解釋模型相對原始模型隻有百分之幾的準確性損失(BiDAF)。這種可以被解釋的內部表達被稱為 Tensor Product Representation:對於每一個輸入詞,模型選擇一個符號對其進行編碼,並將符號放置在特定的角色位上,以兩個屬性表達這個單詞。選擇通過 soft attention 機製形成,總可解釋性是通過符號的可解釋性,以及模型訓練過程構建的——模型學會了用符號和角色表示輸入信息。

我們發現了支持最初假設的根據,符號可以被解釋為詞彙+語義,而角色可被解釋為語法角色(或類別)的近似,如主語、疑問詞、限定詞等等。通過詳細的分析,我們發現了由標準解析器指定的學習角色和部分語言之間的具體對應關係,並發現了模型中經常出現的幾個差異。在這裏,模型學習語法的重要概念僅僅通過未經語言學標記的文本、問題和回答——我們未向模型預先提供語言學知識。給出的隻是使用符號和角色來表示的手段,和傾向於以離散方式使用它們的歸納偏差。