時間:2019-11-20 來源:互聯網 瀏覽量:

正在美國丹佛舉行的 SC2019 是全球超算領域最重要的高端學術交流活動之一。今年 SC 的主題是「超算已來(HPC is now)」。隨著算力的不斷提升,以及先進算法的不斷落地,超級計算機早已不再是科學研究專用的工具,而是已經成為了我們生活當中不可或缺的基礎設施。

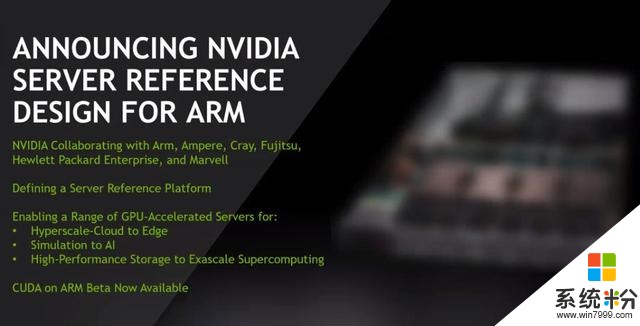

Arm 架構服務器的火熱當然少不了英偉達的參與。今年 6 月,英偉達就在德國宣布了與 Arm 全麵合作的新計劃:兩家公司將合力推動構建超級計算機。而加速計算平台 CUDA 也將支持 Arm 架構,這一行動將為深度學習、高性能計算打開了一條全新道路。

在 SC2019 大會上,這一願景得以實現。

推出基於 GPU 加速器的 Arm 服務器

在大會上,英偉達 CEO 黃仁勳宣布推出最新服務器平台設計,該平台可以使企業能夠快速構建基於 GPU 加速器的 Arm 服務器,從而開辟新的高性能計算(HPC)時代,並滿足越來越多的科學和工業應用。

英偉達表示,該平台由硬件和軟件構建塊組成,可以滿足 HPC 社區不斷增長的需求,從而利用更廣泛的 CPU 架構。它能夠使超級計算中心、超大規模雲運營商和企業將英偉達加速計算平台的優勢與最新的基於 Arm 的服務器平台相結合。

為了構建該平台,英偉達與 Arm 及其生態係統合作夥伴(包括 Ampere、Fujitsu 和 Marvell)展開合作,以確保英偉達 GPU 可以與基於 Arm 的處理器實現無縫協作。該平台還得益於與 Cray 和 HPE 兩家基於 Arm 的早期服務器提供商的大力合作。此外,許多 HPC 軟件公司已使用 NVIDIA CUDA-X 庫來構建可在 Arm 服務器上運行的 GPU 賦能的管理和監測工具。

該平台的首次亮相是在英偉達今年早些時候宣布將 CUDA-X 軟件平台引入 Arm 之前。為了兌現這一諾言,英偉達將預覽其與 Arm 兼容的軟件開發套件,其中包括英偉達 CUDA-X 庫和用於加速計算的開發工具。

致力於更廣泛的 HPC 生態係統合作

除了使自己的軟件兼容 Arm 外,英偉達還與 GROMACS、LAMMPS、MILC、NAMD、Quantum Espresso 以及 Relion 等主要 HPC 應用開發者密切合作,以將 GPU 加速的應用交付給 Arm。英偉達和其 HPC 應用生態係統合作夥伴已經編譯了大量的代碼,以將 GPU 加速引入到 Arm 平台上它們自己的應用。

此外,為了實現 Arm 生態係統,英偉達與 Canonical、Red Hat, Inc. 和 SUSE 等領先的 Linux 發行商以及業界領先的基礎 HPC 工具供應商展開合作。 目前,世界領先的超級計算中心已開始測試基於 GPU 加速的 Arm 計算係統,這其中包括美國橡樹嶺和桑迪亞國家實驗室、英國布裏斯托大學和日本理化研究所。

英偉達希望能夠成為 Arm 生態的一部分,在 HPC,雲計算等領域貢獻自己的力量。不過,英偉達的 Arm 生態目前主要專注於大規模計算的應用,在端側領域,其和高通等公司的合作還不明確。

聯合微軟推出全球最大「雲超算」

還記得英偉達 50 分鍾訓練 BERT 嗎?英偉達和微軟正希望把這樣的強大算力帶給更多人。

除了在架構上的創新之外,英偉達和微軟在大會上共同推出了基於 Azure 雲服務的可擴展 GPU 加速型超級計算機 NDv2。新的微軟 Azure NDv2 可以擴展到數百個用於複雜 AI 和高性能計算(HPC)應用的英偉達 Tensor Core GPU。 被構建用於處理要求最高和高性能的計算應用,Azure NDv2 的部署將使其躋身於世界上最快超級計算機之列,最多可提供 800 個在單個_Mellanox InfiniBand_後端網絡上互通的英偉達 V100 Tensor Core GPU。它使客戶首次可以按需租用整個 AI 超級計算機,並且其性能抵得上花費數月時間才能部署的大型本地超級計算機。

黃仁勳在會上表示:「現在,你可以啟動一台 NDv2 實例,在 container 中抓取一個堆棧,並在 Azure 中啟動它。這就是科學,真是太神奇了!」

黃仁勳宣布推出可在微軟 Azure 雲服務上使用的、GPU 賦能的超級計算機 NDv2。他表示:「這使得世界各地的科學家都可以擁有一台超級計算機。」

性能優越,成本效益高 英偉達表示,NDv2 非常適合複雜的 AI、機器學習和 HPC 工作負載,並且與傳統的基於 CPU 的計算相比,其可以提供顯著的性能和成本優勢。因此,需要快速解決方案的 AI 研究人員可以在短短幾個小時內快速啟動多個 NDv2 和訓練複雜的對話型 AI 模型。

微軟和英偉達的工程師在集群的預發布版本上使用了 64 個 NDv2,在約三個小時內訓練了 BERT(目前最流行的 NLP 模型)。這在一定程度上是利用 NCCL 提供的多 GPU 優化的優勢,NCCL 是英偉達 CUDA X 庫和高速 Mellanox 的連接器。

客戶還可以使用多個 NDv2 來運行複雜的 HPC 工作負載。此外,對於特定類型的應用而言,單個 NDv2 即可以在無需 GPU 加速的情況下,比傳統 HPC 節點快一個數量級的速度得出結果。對於大規模模擬而言,這種性能可以線性地擴展到 100 個 NDv2 實例。

所有的 NDv2 都可以獲益於 GPU 優化的 HPC 應用、機器學習軟件以及出自英偉達 NGC 容器注冊表和 Azure Marketplace 的 TensorFlow、PyTorch 和 MxNet 等深度學習框架。NGC 容器注冊表還提供了 Helm 圖表,從而可以輕鬆地將 AI 軟件部署到 Kubernetes 集群中。

NDv2 目前發布的是預覽版,搭載 8 塊英偉達 Tesla V100 GPU 的 NDv2 可以實現集群化,以實現擴展進而滿足各種工作負載需求。

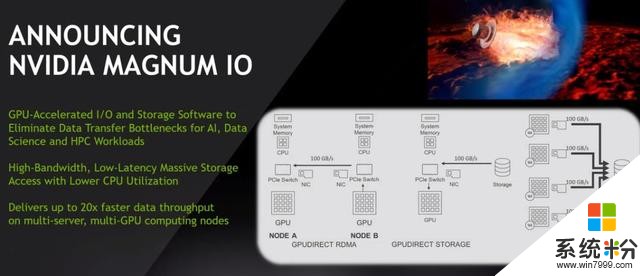

推出 Magnum IO 軟件套件,幾分鍾內實現數據移動

英偉達還在大會上宣布推出 Magnum IO 軟件套件,該套件可以幫助數據科學家以及 AI 和高性能計算研究人員在幾分鍾內實現數據移動,而不再需要幾個小時了。

在全球頂級超級計算機大會 SC19 開幕式上,有近 1400 名研究和技術人員聆聽了黃仁勳的主題演講。

就其性能而言,Magnum IO 進行了大幅度優化以消除存儲和輸入/輸出瓶頸,並且當在大規模數據集上進行複雜的金融分析、氣候建模和其他 HPC 工作負載時,Magnum IO 可以使得多服務器和多 GPU 計算節點的數據處理速度提升高度 20 倍。

黃仁勳表示:「這是一個充滿創新的領域,我們將投入大量的精力幫助用戶高效地實現係統中數據的移入和移出。」

Magnum IO 的核心功能是英偉達 GPU Direct Storage,它在 GPU 內存和存儲之間提供了一個直接的數據通路,使得數據能夠繞過 CPU 並在 GPU、存儲和網絡設備所提供的的「open highways」上暢通無阻地傳輸。此外,GPUDirect Storage 還使研究人員在訪問存儲時可以繞過 CPU,並快速訪問數據文件以進行模擬、分析或可視化操作。

GPU Direct 由對等網絡和 RDMA 元素組成,並且可以與包括 NVLink、NCCL 以及 OpenMPI 以及 UCX 在內的各種通信連接器和 API 兼容。 除了 GPU Direct Storage 功能之外,英偉達 Magnum IO 軟件套件現在可以使用,用戶可以進行搶先體驗。此外,英偉達計劃在 2020 年上半年發布功能更廣泛的 GPU Direct Storage。