時間:2018-09-18 來源:互聯網 瀏覽量:263

選自arXiv,作者:Mingming He、Dongdong Chen、Jing Liao、Pedro V. Sander、Lu Yuan,機器之心編譯,參與:高璿、思源。

圖像著色的目的是為灰度圖像增添色彩,使圖像更具視覺感知力和吸引力。由於圖像的灰度像素可以被輸入許多種顏色(例如樹葉可能是綠色、黃色或棕色),所以這個問題難以解決,它本質都是模棱兩可的。因此目前沒有唯一正確的解決方案,人工介入往往在著色過程中起著重要的作用。

引導著色的手動標注信息通常有兩種形式:用戶引導的塗鴉或樣本參照圖。在第一種形式中,為了得到可信的結果,必須仔細選擇塗鴉或調色板的顏色。這需要豐富的經驗和良好的審美,因此對於未經訓練的使用者來說是一個挑戰;在第二種形式中,為了便於處理,我們需要給出了與灰度圖同類的彩色圖作為色彩基準。為了抽取這種色彩基準,首先需要建立對應關係,然後在最可靠的對應關係上傳播色彩。然而,結果的質量很大程度上取決於參照圖片的選擇。光照、視角、內容不一致等因素會導致參照和目標間有巨大差異,進而誤導著色算法。

利用巨大的參考圖像數據庫搜索最相似的圖像塊或像素進行著色不失為一種可靠的方法。最近,深度學習技術在大型數據建模方麵多有建樹。圖像著色問題可以被看作回歸問題,並利用深度神經網絡直接求解。目前很多方法都可以全自動地給新照片附色,無需任何參考,但是這些方法都無法實現多模態著色 [Charpiat et al. 2008]。他們的模型主要利用從數據中學到的主色調,阻礙了使用者對其它色調的選擇與使用。另一個缺點是,這些模型必須在一個涵蓋所有可能參考圖像的巨大數據庫中進行訓練。

最近的研究都試圖在交互的可控性和學習的魯棒性兩方麵都做到最好。Zhang 和 Sangkloy 等人在深度神經網絡中以色點和筆畫的形式添加人工信息,以便為用戶推薦繪製時最可能需要的顏色。這極大促進了傳統基於塗鴉的交互,並實現了通過大規模數據學習到更自然的顏色。然而,塗鴉對於獲得高質量的結果仍然必不可少,所以還需要一定的試錯。

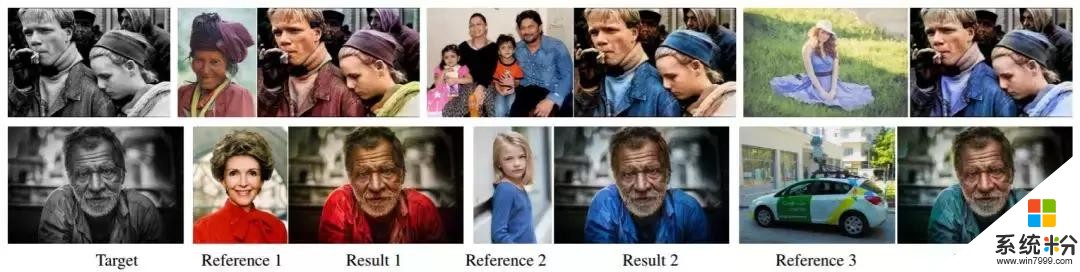

本文中采取了另一種類型的混合解決方案。研究者提出了第一種基於樣本的局部著色方法。與現有的著色網絡相比,該網絡可以通過選擇不同的參照圖來控製著色的輸出。如圖 1 所示,參考圖像可能與目標相似也可能不同,但最後總能得到差不多的色彩結果,這些顏色在視覺上忠於參照圖,並且色彩也非常有意義。

圖 1:黑白照片著色結果。研究人員通過提供不同的參照圖片,能為目標圖像生成多個貼近真實的著色效果。

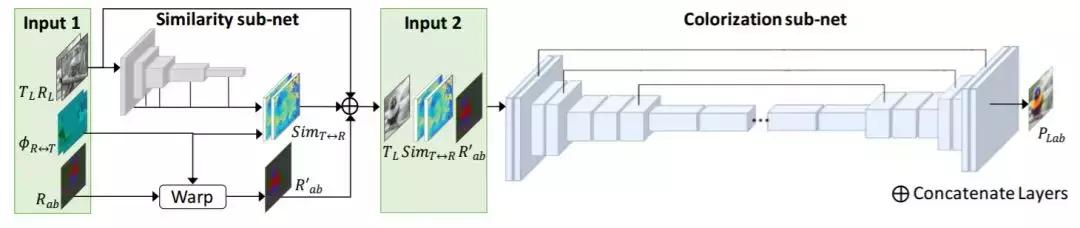

為了實現這一目標,研究者提出了一個卷積神經網絡(CNN),它可以從對齊的參照圖像中直接選擇、傳播和預測灰度圖像顏色。此方法在質量上優於已有基於樣本的方法,它的成功之處在於使用基於樣本著色框架中的兩個新型子網絡。

首先,相似性子網絡(Similarity sub-net)是著一種預處理步驟,它為端到端著色網絡提供了輸入。相似性網絡度量的是在灰度圖像目標識別任務中,利用 VGG-19 網絡預訓練的參照圖和目標圖間的語義相似性。與之前基於低級特征的度量比,它為不同的語義圖像提供了更具魯棒性和可靠性的相似性度量。

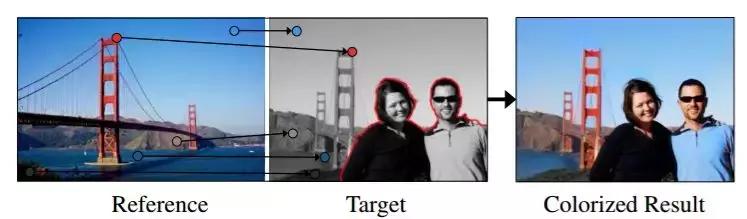

然後著色子網絡(Colorization sub-net)為相似或不同的塊/像素對提供更一般的著色方案。它利用多任務學習訓練兩個不同的分支,兩個分支共享相同的網絡和權重,但損失函數不同:1)色度損失(Chrominance loss),激勵網絡選擇性傳播滿足色彩一致性的相關塊/像素;2)感知損失(Perceptual loss),使著色結果和真色彩圖像在高級特征表示空間上緊密匹配。即使在參照圖中沒有合適匹配區域的情況下(參見圖 2),也能確保從大規模數據中學習到適當的著色。因此,該方法與其它基於樣本的方法不同,它可以大大放寬需要選擇良好參照圖的限製。

圖 2:目標是有選擇地向相關圖像塊/像素傳播正確參照圖顏色(紅點表示),並在參照圖中沒有合適匹配區域(紅色輪廓線表示)時,從大規模數據中預測自然的顏色。

為引導使用者進行有效的參照圖選擇,係統會根據本文所提出的圖像檢索算法推薦最可能的參照圖。它利用高級語義信息和低級亮度統計信息來搜索 ImageNet 數據集中最相似的圖像 [Russakovsky et al. 2015]。在這個檢索算法的幫助下,研究者提出的方法可以看作一個全自動著色係統。實驗表明,該自動著色係統在數量和質量上都優於現有的著色方法,甚至可以和當前最先進的交互方法 [Zhang et al. 2017; Sangkloy et al. 2016] 產生的高質量結果相媲美,此方法也可以擴展到視頻著色。

研究成果如下:(1)提出第一個基於樣本著色的深度學習方法,它具備可控性並對參照圖的選擇有魯棒性。(2)提出一種全新的端到端雙支路網絡架構,當無法獲取優秀的參照圖時,模型會聯合學習有意義的參照圖局部著色和近似合理的色彩預測。(3)提出用於推薦的參照圖像檢索算法,也可用於實現全自動著色。(4)提出一種能遷移到非自然圖像的方法,即使網絡隻在自然圖像訓練集上訓練。(5)可以擴展到視頻著色。

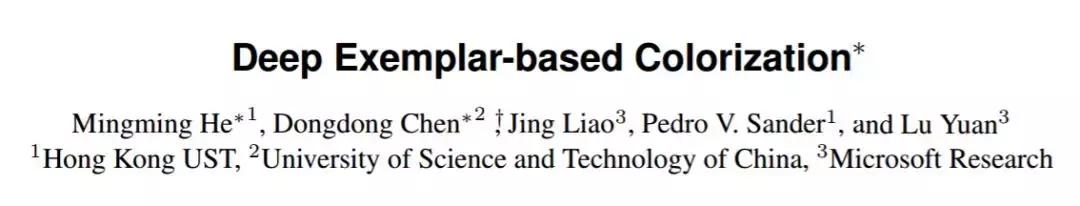

論文:Deep Exemplar-based Colorization

摘要:我們提出了第一個基於樣本的局部著色深度學習方法。當給定一個參照彩色圖像時,我們的卷積網絡將直接將灰度圖像映射到輸出的彩色圖像中。與傳統基於樣本方法的手動標注規則不同,我們的端到端著色網絡會學習如何從大規模數據中選擇、傳播和預測顏色。即使參照圖像與輸入灰度圖像無關,該方法仍然有較強的魯棒性和泛化能力。更重要的是,與其他基於學習的著色方法不同,我們的網絡允許使用者簡單地輸入不同參照圖片,就可實現對應的結果。為了進一步減少人工選擇參照圖像的工作量,係統采用我們提出的圖像檢索算法自動推薦參照圖像,該檢索算法同時兼顧到語義信息和亮度信息。通過簡單地選取推薦參照圖像,即可實現全自動著色。通過用戶調查和與目前最優方法定量比較,我們對該方法進行了驗證。此外,我們的方法可以自然地拓展到視頻著色。代碼和模型都會開源給大家。

圖 3:係統結構圖(推斷階段)。該係統由兩個子網絡構成。相似性子網絡作為預處理步驟使用 Input 1,Input 1 包含兩個分別來自目標圖和參照圖的亮度通道 T_L 和 R_L、雙向映射函數Φ_(T↔R) 和兩個來自參照圖像的亮度通道 R_ab。相似性子網絡計算了雙向相似映射 sim_(T↔R) 和與參照對應的色度通道 R'_ab,兩者連同 T_L 作為 Input 2 輸入到著色子網當中。著色子網是一個用來預測目標色度通道的端到端 CNN,結合 TL 生成最終的著色結果 P_Lab。

圖 10:我們的方法在不同參照圖中的著色表現:手動選擇、自動推薦、在同等目標中隨機選擇、在同類中隨機選擇、在同類之外隨機選擇。輸入圖像基本都選自 ImageNet 數據集,除了 Andreas Mortonus/flickr 和 Indi Samarajiva/flickr 的兩張參照圖片。

圖 12:在 ImageNet 上訓練的著色網絡的遷移能力比較。輸入圖像(從左到右,從上到下):Charpiat et al. [2008], Snow64/wikimedia 和 Ryo Taka/pixabay。

圖 14:與基於學習的方法進行比較。輸入圖像:ImageNet 數據集。

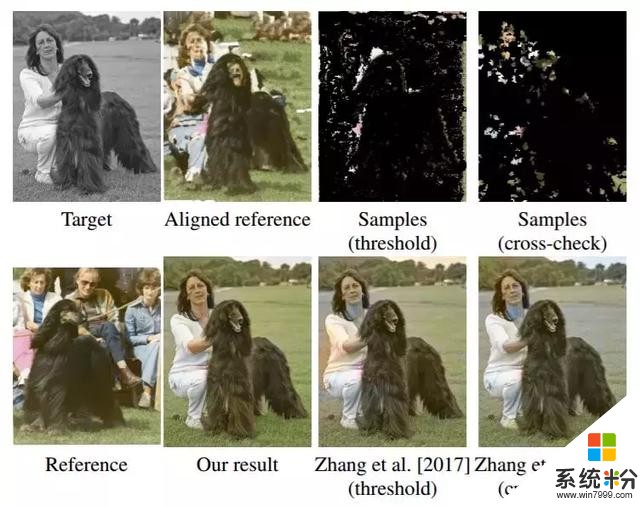

圖 9:包含手動閾值選擇顏色樣本和交叉匹配的端到端網絡與 Zhang 等人著色方法對比。輸入圖像:ImageNet 數據集。