時間:2018-05-12 來源:互聯網 瀏覽量:

按:這些天,穀歌AI冒充真人打電話在朋友圈大火,可以說穀歌很成功地製造出了一次熱點話題。然而,這可忙壞了微軟集團的公關們,不得不趕緊發技術聲明表示微軟早已實現了AI與真人通電話。

美國時間5月8日,穀歌在2018年度開發者大會(Google I/O 2018)上介紹了智能語音助手Google Assistant中新增加的Duplex,它可以自己給飯館、發廊等商業店麵打電話,幫用戶預約時間。我們再來看看I/O 大會現場的演示視頻:

AI助手與人交流、完成指令已經不是新鮮事。如果你經常跟Siri對話,或者你有一台天貓精靈、小愛同學等智能音箱,你會發現,跟AI對話實在是太費勁。你需要字正腔圓,還要一次次地說喚醒詞,無法實現連續對話。

Duplex讓人感到驚訝的是:它不僅用自然流暢的語音和電話另一頭的人類完成了交流,且對方根本沒有意識到打電話來的居然是個[ AI ]。這是因為穀歌Duplex實現了連續對話、加入了人在對話中通常會用的語詞助詞"emm"、“uha”等、能理解對話的上下文,此外還具備了主動提供語料的功能。

這樣的雙向對話,一直是微軟、蘋果、亞馬遜、Facebook這些做對話式人工智能的公司們努力的方向。穀歌這次放了個大招,獲得了很高的關注,微軟顯然坐不住了,趕緊站出來說,且慢,我們才是先實現這項技術突破的。

關於這件事,微軟在昨天發了一篇技術聲明。以下為聲明全文:

全雙工語音技術(Full Duplex)的意義在於,它能夠使“人機交互”進化為“人機交流”。一字之差,價值巨大。

今年4月4日,我們正式在美國和中國同步發布了Full Duplex感官,並預言行業將意識到這一技術的價值,加快向這一方向集中。我們很高興看到越來越多的同行業者加入。

其實,人類曆史上第一次與人工智能進行全雙工語音電話,並不是發生在美國,而是發生在中國。我們很榮幸能將這一桂冠奉獻給祖國。自2016年8月起,微軟(亞洲)互聯網工程院通過人類用戶主動發起的方式,已讓小冰與人類用戶累計完成了超過60萬通電話。

今天,我們公布其中一通發生在兩年前的實際電話錄音,將之作為珍貴的資料,奉獻給全世界說中文的華人。

而這一技術也已經完成產品落地。兩年來,正是在人類的訓練下,小冰已實現不局限於任何封閉域,而是可針對開放域進行全雙工語音對話。目前,微軟已落地的對話場景包括傳統電話、VoIP電話和智能音箱設備,微軟小冰的車載路試正在進行中。

如果您想要體驗Full Duplex全雙工語音,不需等待數周,今天就能。在微軟小冰已落地的產品中,我們推薦您使用我們與小米合作的米家生態鏈Yeelight智能硬件產品。在隨附的用戶真實使用視頻中,您將體會到:

• 一次喚醒之後的連續對話

• 微軟小冰對用戶的預測模型

• 幫助用戶輕鬆完成多重任務

• 小冰的內容創造能力

• 以及最重要的:人機情感交流

人工智能時代已來,讓我們持續創新。

微軟的聲明中,發現了三個關鍵點:首先,在技術層麵上,微軟在今年4月4日正式發布了“全雙工語音交互”技術;其次,在事件事實上,微軟在兩年前就實現了AI與人類通電話;最後,在產品落地上,微軟的全雙工語音交互已經具備多個場景,且搭載全雙工語音交互技術的微軟小冰已經出現在智能音箱——米家生態鏈Yeelight智能硬件產品中。

微軟所說的全雙工語音交互技術(Full-Deplex Voice)與穀歌Duplex的技術框架和實現的功能應該是類似的。

微軟對“全雙工語音交互技術”的定義是:與既有的單輪或多輪連續語音識別不同,這項新技術可實時預測人類即將說出的內容,實時生成回應並控製對話節奏,能理解對話場景在訴說者/傾聽者之間實現角色轉變,還可以識別說話人的性別、有幾個人在說話。

也就是說,與隻能實現單輪的語音的智能語音助手不同,能連續對話的全雙工語音交互能實現和人類雙向交流,而這種雙向交流最常見的場景則是通電話。因為通電話是一個在短時間內持續對話的過程,對通話雙方的即時反應要求最高。

在3月28日,微軟也在北京召開了媒體交流會,詳細介紹過”全雙工語音交互技術“。

了解到,全雙工語音交互背後主要有兩個關鍵技術:一個是預測模型,實現邊聽邊想;例如,當用戶說出一句話的時候,小冰會先回答“嗯,你說”,然後再去完成指令,這樣就可以填補完成指令的空白時間。

另一個是生成模型(LSTM),能更好理解場景,自動生成回複。正常的對話都不是單向的一問一答,小冰也會在適當的時候主動提供內容,並且能知道在用戶完成指令沉默幾秒後自動結束對話。現在運用了全雙工語音交互技術的微軟小冰的所有回複都是自己生成的,有別於傳統的基於模塊、搜索來進行的回複。(關於微軟全雙工語音交互技術可以查看此前報道:《微軟發大招:要做智商和情商兼具的語音助手》

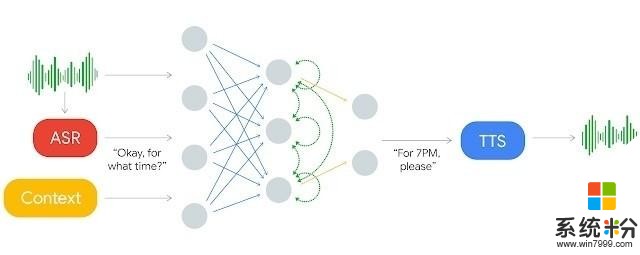

在對穀歌Duplex的技術解析文章中也提到,Duplex的核心是一個RNN(循環神經)網絡,由TensorFlow Extended(RFX)構建,穀歌用匿名的電話對話數據訓練了Duplex的RNN網絡,這個網絡會使用穀歌自動語音識別(ASR)的識別結果文本,同時也會使用音頻中的特征、對話曆史、對話參數(比如要預定的服務,當前時間)等等。

輸入語音先經過自動語音識別係統(ASR)處理,生成的文本會與上下文數據以及其它輸入一起輸入 RNN 網絡,生成的應答文本再通過文本轉語音(TTS)係統讀出來。

穀歌用的生成模型是RNN,而微軟用的是LSTM,從體驗來看,兩者實現的效果很接近。跟Yeelight中的微軟小冰對話時,能實現一次喚醒連續對話長達20分鍾,有適當的語氣詞,能主動提供預料,主動結束對話。

在穀歌I/O大會的最後一天,獲得年度圖靈獎的Alphabet新任董事長John Hennessy宣布:"在預約領域,穀歌Duplex通過了圖靈測試“。也就是說,目前穀歌Duplex與人類展開對話,人類無法識別出其是機器人。這個消息,確實令人振奮。與搭載了微軟全雙工語音交互技術的微軟小冰相比,穀歌Duplex的一大特色是其聲音和語調與真人幾乎一致,這是他們花費了數月時間采集真人聲音訓練而成的結果。

穀歌稱,今年夏天會開始基於Google Assistant測試Duplex,從預訂餐館、預訂發廊、詢問節假日的營業時間這樣的事項開始。而微軟小冰則是將人工智能助手和聊天機器人結合起來,努力進入各個場景,包括傳統電話、VoIP電話和智能音箱設備,微軟小冰的車載路試也正在進行中。

(Yeelight微軟小冰用戶體驗視頻)

微軟全雙工語音技術已經在做產品落地,卻被還在測試中的穀歌Duplex搶占了熱點,難免有一點著急。

然而如果我們回想技術發展的曆程,我們會記得,1844年,莫爾斯從從華盛頓到巴爾的摩拍發人類曆史上的第一份電報,說的是:"上帝呀,你究竟幹了一些什麼?”;1876年,貝爾發明世界上第一台電話,他說的第一句話““沃森先生,快來幫我”成為人類第一句通過電話傳送的語音。然而,人工智能助手與人類的第一通電話顯然就難以定義了,畢竟我們在人工智能的道路上,還有很長的路要走。