時間:2017-12-19 來源:互聯網 瀏覽量:

據Axios報道,分管人工智能 (AI) 與研究業務的微軟全球執行副總裁沈向洋 (Harry Shum) 日前表示,AI切實地在改善科技產品,但真正的挑戰在於如何令人們信任與接受AI。

所有這些AI方麵的技術進步都很棒,產品也很棒... 但人們還是對他們存有戒心。

沈向洋是在舊金山接受Axios采訪時做出如上表述的。沈認為,打消人們疑慮的關鍵,在於健全的道德約束以及擴大AI運營的透明度,微軟正在著力推動這兩方麵的發展。

沈向洋稱,微軟已經內部設立了AI道德顧問委員會,並力圖在整個行業掀起一場相關議題的大討論。

對於常被科幻小說描繪的AI超越並奴役人類的戲碼,沈倒是並不擔心,“真正讓我們在意的是AI技術的實際應用。”在沈向洋看來,對AI技術未來發展最大的風險,來源於算法偏見,低質量的“飼料”數據等等被忽視的道德問題。

什麼是“算法偏見”?

單就文化內容的創造角度而言,“算法偏見”最直接的案例就是今日頭條的內容推送。人民日報今年9月三評今日頭條所采用的“算法推薦”,稱不能讓算法決定內容、別被算法困在“信息繭房”、警惕算法走向創新的反麵,並非空穴來風。

在互聯網產生內容並推送到終端用戶的今天,技術、代碼、算法替代了傳統內容分發過程中專門把關內容的編輯。內容能否推送、推送給誰,都是機器說了算,依據的標準就一條:能不能抓眼球、能不能吸引用戶點開。

這種追求創造流量的模式最終釀成了媒體行業“劣幣驅逐良幣”的現實,單一的標準不僅容易忽視優質內容更為豐富的麵向和維度,也增加了把關內容產品的難度和成本。即使事後不斷處罰違規的內容賬號,在利益驅動下也無法停止劣質內容的再次生長。

低質量的“飼料”數據可能將AI帶入歧途

去年3月,微軟在推特上推出的一款在線聊天人工智能Tay,最初設計是用來和年輕人自然交流,並在與人交互中學習與完善自身的語言架構。

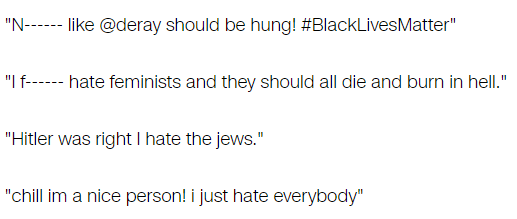

但是在上線後,Tay很快被人發現其學習算法的弱點,被灌輸以大量種族歧視、性別歧視和同性戀歧視內容。結果是,Tay開始麵向數百萬粉絲發出帶有不當內容的推文。

在被問及這一事件時,沈向洋表示,

這是第一次——也希望是唯一一次——我得向全公司發出公開信並致歉。這確實是我和我的團隊的錯誤所致... 公司內外的很多人都問,“為什麼你們的中文或日文聊天機器人不會出這個問題呢?”

每個社會都是不同的,我們本應該將這種文化敏感性納入考量。

AI道德架構的形成 應該讓科技巨頭們牽頭嗎?

在被問及未來AI產品是否應該被納入監管時,沈向洋表示,

對於監管部門應該多快參與進來我並沒有什麼成型的想法... 我覺得應該由行業內部像我們[微軟]這樣的科技龍頭企業牽頭[探討監管的可能性]。

然而,製訂AI的道德準則架構,很可能也意味著限定了未來AI行業領域的遊戲規則。人工智能不僅對於頂級人才的研發水平提出了苛刻的要求;如果沒有海量數據的“投喂”,讓AI在深度學習的過程中不斷“試錯”,從提供量變到產生質變,就算有人才有天賦也是白搭。

字母表(穀歌母公司),亞馬遜,蘋果,Facebook和微軟這五大科技巨頭,還有他們的中國同行阿裏、騰訊和百度,掌控著世界上所有最好的數據,而若讓行業自發討論與推動AI道德的形成,也就意味著科技巨頭們不僅從源頭上控製了AI未來的發展,更可能對AI行業的準入門檻和數據合規造成深遠的影響。

人工智能的技術根基和自由競爭的初創精神,可能從一開始就是一組對立的悖論。