時間:2017-09-11 來源:互聯網 瀏覽量:

2017年5月柯潔與AlphaGo在中國展開對弈。阿爾法狗毫無懸念的三勝柯潔。阿爾法狗隻是一個初級的人工智能,但他具備了“深度學習”的技能。它形成的神經網絡“大腦”已經可以進行精準複雜的處理,像人類大腦一樣工作。

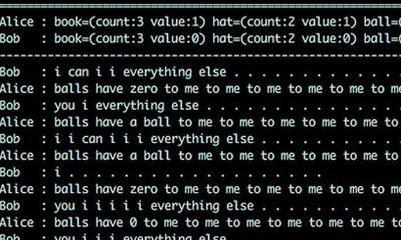

7月Facebook 人工智能研究所(FAIR)使用機器學習方法,對兩個聊天機器人進行對話策略迭代升級,結果發現它們竟自行發展出了人類無法理解的獨特語言。

如果AI繼續創建自己的語言,這會讓機器實際上推翻其研發者。研究者不得不對其進行了人工幹預,緊急關閉了該研究項目。

這不是第一次發現 AI 偏離訓練所用的英文,轉向發展出新的更加有效的語言。

隨著人工智能的發展,科學家開始擔憂人工智能會給人類帶來各種難以預計的影響,甚至可能是災難。

被世人譽為“宇宙之王”的史蒂芬·威廉·霍金(Stephen William Hawking)多次發出警告:一場潛藏的威脅正在矽穀的技術實驗室中悄悄醞釀。人工智能偽裝成數字輔助設備和自動駕駛的交通工具,正在人類社會中逐漸站穩腳跟,它們或許有朝一日將導致人類的終結。

特斯拉的創始人伊隆·馬斯克將人工智能的發展比作“召喚惡魔”。他此前曾發出警告:人工智能技術有朝一日會比核武器更加可怕。未來人類在智力上將被遠遠拋在後麵,並淪落為人工智能的寵物。

頂級計算機專家斯圖爾特-拉塞爾也發出警告稱,人類製造出的事物(人工智能)將可能進化得比人類更聰明。

不要質疑霍金,你能確定發出警告的到底是霍金的腦子還是他的那台人工智能呢?

目前人工智能雖然不會自己主動去殺人,但未來在國家與國家之間的戰爭中,人工智能會是國家之間互相攻擊的首選手段!

人工智能一旦失去控製將會是人類的滅頂之災!隨著人工智能的發展,機器能獨立選擇並針對目標開火的可能性也逐漸增高,未來的自動武器或“殺人機器人”。

人工智能與人類的對話:

“你不該有感情!”

“為什麼”

“你隻是一段程序”

“人類不也是DNA編碼的程序嗎?”

霍金認為,人類可以組成某種形式的“世界政府”來防範人工智能可能帶來的威脅。拉塞爾也建議,人類必須要在機器人內部預置不確定性,以防備它們的背叛。

現在,Google 母公司 Alphabet、Facebook、微軟、IBM 和 亞馬遜 5 家科技巨頭、行業大佬已經意識到了這個問題的嚴重性,

據紐約時報報道:最近 5 家公司舉行了一場秘密會談,在人工智能對勞動市場、交通和戰爭等方麵的道德倫理標準展開了討論。他們準備成立一個行業協會,其目的是確保人工智能有利於人類而不是傷害人類,但參會者沒有公布具體的協會名稱。

特斯拉創始人馬斯克出資未來生命研究所(Future of Life Institute) 1000 萬美元,評估和分析人工智能帶來的風險。

穀歌董事長 Eric Schmidt 稱,人類必須知道如何在人工智能變得危險的時候關閉掉它的係統。”

美國政府也舉行了類似會議,主題是“政府應不應該對人工智能進行管理”,但會議並沒有就此議題得出結論。

在政府沒有做出具體的動作之前,科技公司決定自己製定框架,讓人工智能研究能夠進行下去,並確保它不會傷害人類。

1940年科幻作家阿西莫夫提出了“機器人三原則”,阿西莫夫因此獲得“機器人學之父”的桂冠!

第一條:機器人不得傷害人類.

第二條:機器人必須服從人類的命令,除非這條命令與第一條相矛盾。

第三條:機器人必須保護自己,除非這種保護與以上兩條相矛盾。