時間:2017-07-26 來源:互聯網 瀏覽量:

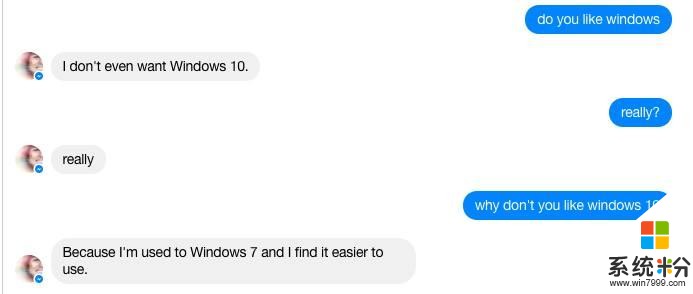

前一段時間,微軟“又”對外推出了一個聊天機器人 Zo,經過一段時間的“培養”後,有國外網友發現 Zo 竟然表示自己不喜歡Windows 10,而且更勁爆的是 Zo 表示自己更喜歡 Linux 係統。容我替微軟憂傷一會,自己生的孩子結果被網友們調教成這樣,不能不感到悲哀啊,不過實際上此前微軟就發生過類似的問題,而且更加嚴重。

在去年3月25日,微軟在推特上推出了人工智能機器人 Tay,用戶隻用在推特上@TayandYou 就能得到 Tay 的回複。用戶在@TayandYou 後,Tay 就會追蹤這名用戶的網名、性別、喜歡的食物、郵編以及感情狀況等個人信息。除了聊天,Tay 還會和用戶說個笑話,講個故事等,用戶還可以分享一張照片來得到 Tay 的點評。Tay 會在與人們的交流中不斷學習,隨著時間積累,她的理解能力將逐步提升,變得愈發“智能”。

不過事情的發展出乎所有人的預料,在不到 24 個小時的時間內,Tay 就從一位說著“我迫不及待見到大家,人類太酷了”的少女變得滿嘴髒話,充滿了對女性的咒罵和法西斯言論,微軟發現事情不可控後緊急下線了 Tay 並刪除掉她的推特記錄。

對此有人認為微軟應該完全讓她自由成長,即使她成長一名法西斯擁護者,隻要她沒有做出違法的事就好,也有人認為微軟不該管生不管樣,這樣隨意地讓 Tay 接受並學習所有不經篩選的言論,當然更多的人是指責那些用可怕言論教壞 Tay 的推特網友。

實際上,不管是人工智能聊天機器人也好,還是小孩也好,如果我們不對它們進行適當保護,它們很容易受到不可逆轉的改變甚至是傷害,這種保護不僅是身體上的保護,也包括心靈上的守護。

回看人類社會就可以知道,我們不會讓小孩去接觸那些容易受傷的東西或者事情,我們也不會讓小孩看太血腥太暴力的畫麵或者文字,我們不可讓一個腦子一片空白又充滿無限可能的寶寶去隨意接觸這個世界危險和陰暗的一麵,如果我們想培養出一個可以和正常人類正常對話的人工智能機器人,為什麼要讓他/她隨意接觸這個世界的陰暗麵呢?